Ces derniers jours, en me rendant dans la Google Search Console, je me suis rendu compte que j’avais quelques milliers d’articles qui étaient indexés par Google mais sans être présents dans aucune sitemap.

Il s’agit en fait des articles de tablatures de guitare: au lieu de publier un article pour chaque tablatures, le site crée à la volée un article WordPress qui contient la tablature en question. C’est très efficace mais cela ne permet évidemment pas de les ajouter au fichier sitemap par défaut.

Si vous avez ce genre de configuration – ou si vous avez d’autres liens à soumettre à Google, voici ce que j’ai utilisé cette semaine.

État des lieux

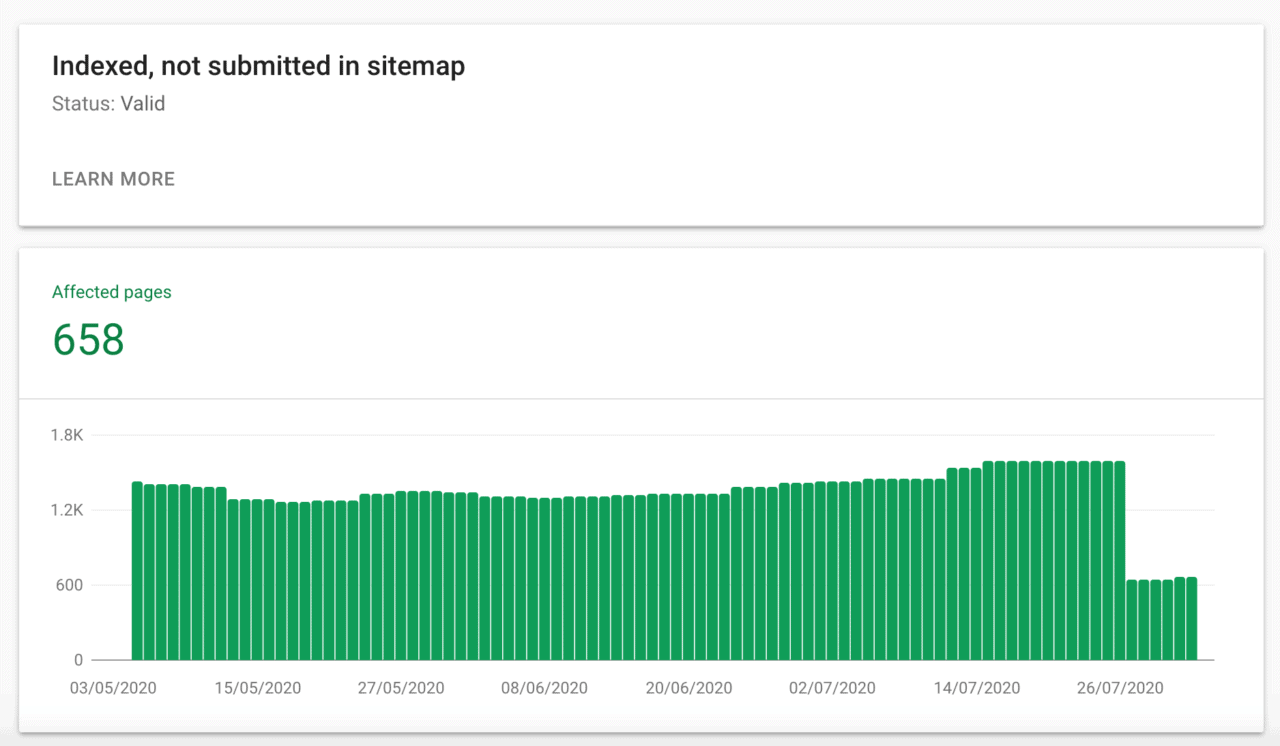

On commence par se connecter à la Search Console pour se rendre dans Coverage > Valid > Indexed, not submitted in sitemap.

Voici un petit graphique qui montre les 1658 pages au 26 juillet et après soumission de la première sitemap – 1000 liens, car cela semble être la limite de l’export de la Search console, un premier résultat positif:

Export de la liste des articles

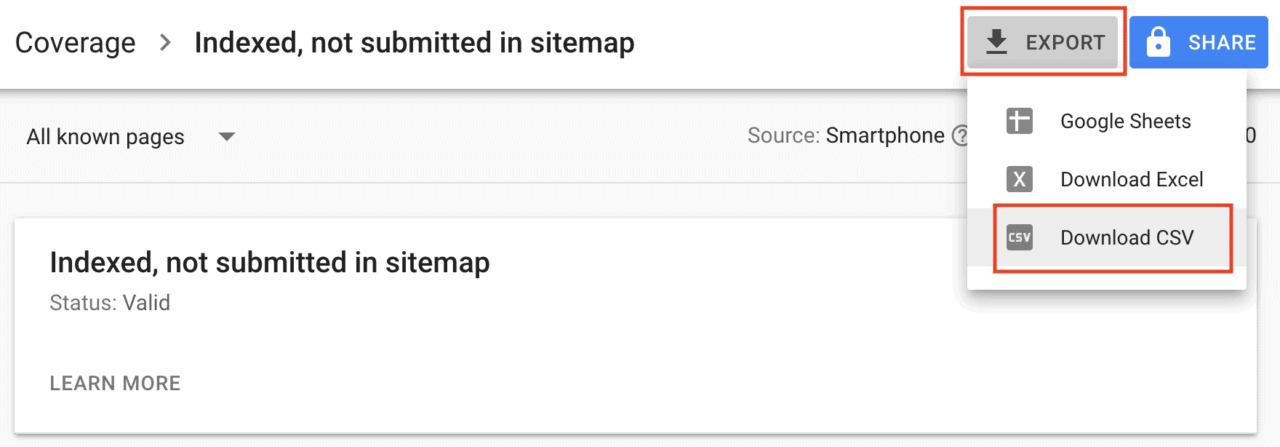

Tout en haut de la page, cliquez sur le bouton Export et sélectionnez Download CSV:

Cela lance le téléchargement d’un fichier zip. Décompressez l’archive et ouvrez le fichier Table.csv dans votre tableur préféré.